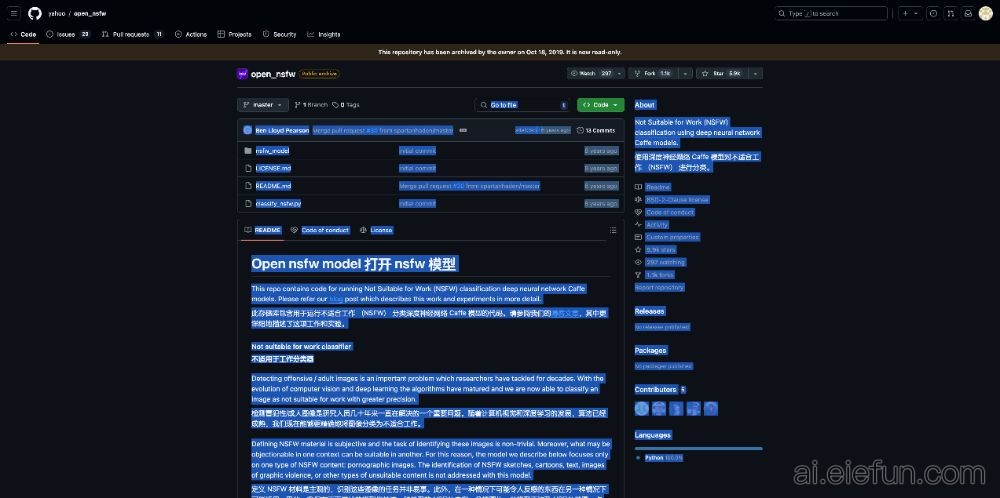

yahoo/open_nsfw 是一个开源项目,旨在通过深度神经网络模型对不适合工作(NSFW)图像进行分类。该项目使用 Caffe 框架,通过训练模型来识别色情内容,从而帮助开发者过滤互联网上的冒犯性或成人图像。

本项目的核心功能是接收输入图像并输出一个概率分数,该分数用于判断该图像是否适合工作。具体来说,得分低于0.2的图像被认为可能是安全的,而得分高于0.8则表示该图像很可能是不适合工作的。中间范围的得分可以用于不同 NSFW 水平的分类。

为了提高结果的准确性,建议开发人员根据特定的数据集和用例选择合适的阈值,并对模型进行微调。此外,结合人工审核可以进一步提升性能,以应对边缘案例。

该项目面向需要处理用户生成内容的平台和应用开发者,尤其是那些希望自动化内容审查流程的网站、社交媒体、在线社区等。由于数据集的性质,本项目无法公开具体数据,但提供了完整的代码和使用文档,便于开发者快速上手。